Позиции в Яндекс: XML или парсинг поисковой выдачи?

23.08.2022 Яндекс изменил алгоритм работы одного из запросов, который используется для парсинга поисковой выдачи ― GET-параметра numdoc. Это повлияло на сбор данных для SEOWORK, в результате чего мы вынуждены уменьшить сборы позиций с ТОП-100 до ТОП-30. Изменения никак не затронули расчет метрик видимости, таких как PTraf и ТОП3-10, а значит качество аналитики не пострадало.

Подробнее расписали ниже:

В чем разница между способами съемов позиций XML/HTML?

Плюсы/Минусы в способах съема позиций

Как собирались данные по позициям в SEOWORK?

Что изменилось в работе Яндекс 23.08.2022?

На что повлияли изменения Яндекса в SEOWORK?

Расходы на SEOWORK на съем данных стали больше в х1.5

SEOWORK сохранил скорость загрузки данных

На какие страницы/отчеты в SEOWORK повлияли изменения Яндекса?

Как учитывать изменения с точки зрения аналитики?

Что делать если критично наличие ТОП30-ТОП100?

Что будет с инструментом ТОП100?

В чем разница между способами съемов позиций XML/HTML?

Собирать данные по позициям в Яндексе можно несколькими способами, основные ― API и парсинг выдачи (HTML). Давайте разберемся, в чем разница, какие плюсы и минусы есть у каждого варианта и почему в SEOWORK используется только парсинг.

Получить XML через API Яндекс несложно. Официальная позиция Яндекса: XML — возможность собирать данные о поисковых запросах к Яндексу и публиковать эту информацию в открытом доступе. Данные выдаются в едином формате, и зачастую они не совпадают с реальной выдачей на 100% (в официальных документах Яндекс не гарантирует точного соответствия результатов поиска, полученных с помощью сервиса Яндекс.XML, результатам, полученными с помощью поисковой системы Яндекса)

Парсинг выдачи (HTML) производится непосредственно по результатам выдачи по конкретному запросу. Этот способ технически сложнее, дольше и дороже. Тем не менее, данных полученных таким методом значительно больше, и они ценнее для аналитики ― это 100% повторение поведения пользователя с учетом множества факторов, которые не отдаются в XML.

Но вместе с тем, для этого метода требуется колоссальная техническая база: чтобы получать данные по большому объему семантики, требуется много парсеров. Они задействуют очень большой объем нагрузки на систему и нуждаются в постоянном мониторинге техническими специалистами. Иными словами, это все очень не просто!

Данные | XML | HTML |

Позиция сайта в поисковой выдаче | + | + |

Наличие и количество блоков контекстной рекламы над поисковой выдачей | - | + |

Наличие и количество блоков контекстной рекламы под поисковой выдачей | - | + |

Наличие быстрого ответа (результата выдачи на "нулевой" позиции) | - | + |

Наличие колдунщиков (Яндекс.Маркет, Яндекс.Видео, Яндекс.Картинки, Auto.ru) | - | + |

Несколько результатов одного сайта по поисковому запросу | - | + |

Наличие блоков с уточняющими поисковыми запросами | - | + |

Наличие сниппетов | - | + |

Плюсы/Минусы в способах съема позиций

Основные и бесспорные плюсы XML ― простота, скорость и дешевизна получения данных.

Минусы серьезные:

Достоверность информации. В XML, которую отдает Яндекс, есть расхождения с реальной выдачей. С точки зрения аналитики данных, это критично. Особенно это заметно сейчас: в ecommerce каждый день с рынка уходят бренды или компании, и поисковая выдача меняется каждую неделю.

Скудность информации. По данным из XML нет возможности видеть полную картину в поисковой выдаче. А сейчас, как никогда, на CTR влияют и количество блоков рекламы, и наличие нулевой позиции, и наличие колдунщиков ― то есть, даже находясь на 1 позиции, можно получать довольно мало переходов.

Парсинг реальной выдачи позволяет оценить полную картину, а именно:

получать максимальное свежие и “чистые” данные, на 100% совпадающие с реальной поисковой выдачей,

оперативно отслеживать динамику по каждому запросу в необходимой для бизнеса глубине,

использовать дополнительные данные: есть ли реклама в выдаче, сниппеты, title, нулевая позиция, используются ли какие-то еще сервисы Яндекса на странице результатов,

анализировать конкурентов в режиме realtime (практически).

Главные минусы парсинга ― высокая стоимость, потребность в больших мощностях для объемных сайтов и сложность их получения.

Как собирались данные по позициям в SEOWORK?

Данные в SEOWORK собирались с помощью парсинга поисковой выдачи (HTML). Процесс парсинга данных довольно дорогостоящий, для этого задействуются большие серверные мощности. Чтобы загрузить ТОП-100 Яндекс, мы осуществляли 2 сбора результатов поисковой выдачи по ТОП-50, для пользователей — это стоило всего 3 коп. за обращение.

Что изменилось в работе Яндекс 23.08.2022?

23.08 Яндекс изменил алгоритм работы одного из запросов, который используется для парсинга поисковой выдачи ― GET-параметра numdoc. С помощью добавления numdoc в URL выдачи можно было увеличить количество ссылок на странице результатов поиска до заданного числа. То есть изменить стандартные 10 ссылок на странице Яндекса до, например, 50.

Теперь действие параметра изменилось: для него настроено максимальное значение ― не более 10 документов на странице выдачи результатов.

На что повлияли изменения Яндекса в SEOWORK?

Если раньше, чтобы собрать ТОП-100 в SEOWORK, мы осуществляли 2 сбора результатов поисковой выдачи по ТОП-50, то сейчас, осуществляя 3 сбора по ТОП-10, мы можем получать только ТОП-30.

Для того, чтобы как и раньше собрать ТОП-100, нам потребуется сделать в 5 раз больше запросов.

Расходы на SEOWORK на съем данных стали больше в х1.5

В SEOWORK тарифицируются сами сборы независимо от их глубины, то есть количество наших сборов увеличилось, но число получаемых данных уменьшилось.

При этом изменении стоимость съема данных для нас стала в 1.5 раза выше. Но при этом увеличение наших расходов никак не отразится на пользователях. Стоимость в рамках тарифов останется прежней.

SEOWORK сохранил скорость загрузки данных

Мы практически полностью переделали алгоритм сбора данных по всем модулям и внесли множество изменений, чтобы сохранить корректность прежних метрик.

Благодаря этому мы получаем данные с прежней скоростью. Если бы SEOWORK собирал ТОП-100 как и раньше, то скорость загрузки данных упала бы до 2 дней.

На какие страницы/отчеты в SEOWORK повлияли изменения Яндекса?

Максимальная глубина в конкурентах.

Конкуренты с низкой видимостью по собранному семантическому ядру не будут видны. Это не проблема, поскольку они не подходят для анализа либо в силу низкой оптимизации, либо из-за несколько иной тематичности. Другой вопрос, есть ли совпадения по какому-то направлению — у платформы есть возможность аналитики в разрезе категорий.

Графики ТОП30-100

Теперь вместо ТОП-100 будет сниматься ТОП-30. Если страница ранжировалась по запросу с 31 по 100 позицию, то теперь этой страницы не будет видно на графике. Она резко просядет, но на графике появится информирующая пометка.

Позиции ТОП30-100 из Яндекс

Данные за ТОП-30 будут недоступны так же, как сейчас данные за ТОП100.

Средняя позиция (Avg position)

В модуле “Видимость” средняя позиция теперь будет варьироваться в рамках ТОП-30. Значения по этой метрике изменятся с 23.08. До этого значение страницы, находившейся за пределами ТОП-100, принималось за 100. В рамках работы с ТОП-30 значение страниц, выходящих за диапазон, соответственно, равняется 30.

Выгрузки по ТОП100

Будут фигурировать только сайты, находящиеся в ТОП-30.

Как учитывать изменения с точки зрения аналитики?

В целом, ограничение сбора до ТОП-30 не сильно влияет на аналитику данных, поскольку запросы, находящиеся на 4 и глубже страницах, не приносят поискового трафика и обладают довольно низкой релевантностью. Другими словами, эти позиции носили скорее информационный характер. Нахождение страницы за ТОП-100 сообщало либо о низком качестве страницы, либо об отсутствии её в индексе. С прикладной же точки зрения, страница, находящаяся за ТОП-30, нуждается в оптимизации. Понять, находится ли страница в индексе, можно и сейчас через модуль “Инструменты”, для этого не нужно снимать позиции.

Самое главное:

Нет влияния на PTraf

Эта метрика считается по CTR для 10 позиций. Все, что ранжируется ниже, имеет нулевой PTraf, а значит не анализируется по этой метрике.

Нет влияния на ТОП-10/3

Принципы аналитики этих ТОП остались прежние, изменения не затронули лидирующие позиции.

Нет влияния на важных конкурентов

Под важными конкурентами мы понимаем проекты, которые находятся на высоких позициях поисковой выдачи. Выход конкурентного ecommerce за пределы ТОП30 не несет ценности для аналитики.

Что делать, если критично наличие ТОП30-ТОП100?

Если для вас критично наличие данных ТОП30-ТОП100, то:

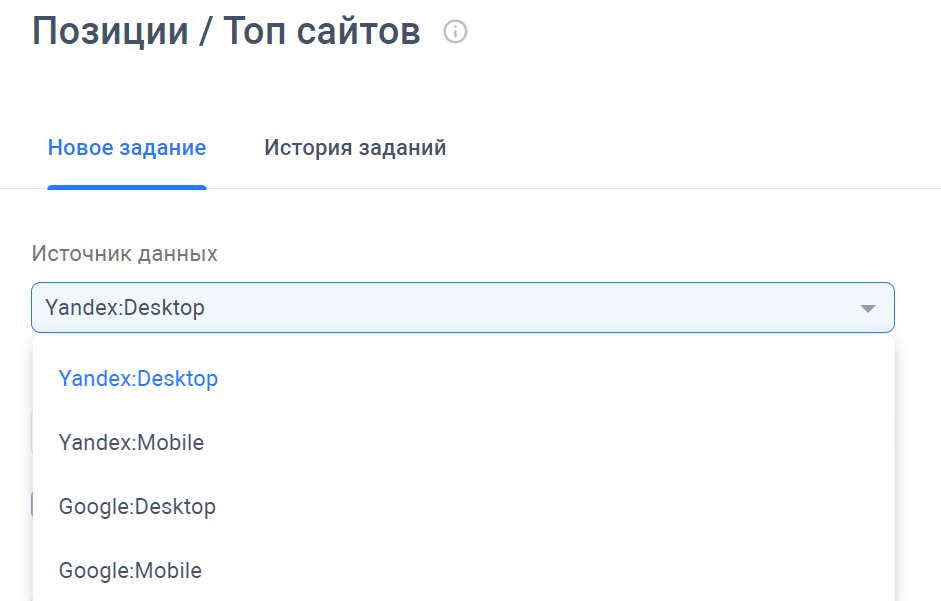

1. Возможен перевод на сбор XML.

2. Можем обсудить и помочь с правильным переходом, с точки зрения анализа данных. Вместе найдем верное решение, исходя из вашего проекта.

Пишите на help@seowork.ru или в чате.

Что будет с инструментом ТОП-100?

На данный момент для HTML выдачи можно собирать только ТОП-20.

Мнение экспертов

Сергей Вирясов, Head of SEO СТД «Петрович»:

В работе с e-commerce я провожу аналитику внутри лидеров выдачи, то есть смотрю проекты, которые занимают в поиске позиции ТОП3-10. Информация за пределами ТОП30 не сильно опорная для аналитики. Интересно еще посмотреть с 11 позиции по 20 для наблюдения за динамикой. Остальное трупы, очевидно.

Андрей Джилавдаров, Эксперт SEOWORK:

Я не уверен в крайней необходимости сбора ТОП-100. Это полезная самопроверка один раз в несколько месяцев для какой-то выборки маркерных запросов в рамках мониторинга проекта или постапдейтной аналитики, но никак не первостепенная задача. Для измерения динамики продвижения ТОП-30 более чем достаточно, это оптимальный диапазон для отслеживания проектов. Если выбирать, то парсинг 30 позиций живой выдачи окажется куда более прикладным, нежели готовый файл XML. XML сборка иногда очень сильно отличается от реальности, так как Яндекс отдает ее сразу ботам, многие моменты не учитываются. Там нет учета части фильтров, колдунщиков, расширенных сниппетов и прочих вводных для качественной аналитики. Лично я XML не использую лет 7. Если есть возможность снимать живую выдачу — нужно снимать ее. Это дороже, но, в моем понимании, это необходимо для качественной аналитики продвижения своего сайта и аналитики ниши по конкурентам.

Если же говорить про измерение динамики, например, рост позиции с 80 на 45, то эта информация больше подходит для измерений в Google, потому что там большее влияние оказывает ссылочная оптимизация. В Яндексе не так, достаточно сделать хорошую on page оптимизацию, структуру сайта, присвоить нужный регион, и страницы сразу попадают в ТОП20-30. За редким исключением в супер мега перегруженных нишах типа МФО или Беттинг по ВЧ запросам могут быть позиции выше 30 места, но оптимизаторы, которые с этим работают, прекрасно понимают и сами. Но если говорить о классических SEOшных метриках, таких как %ТОП-3, %ТОП-10, %ТОП-50 (у всех свои метрики), то переход на снятия позиции только по ТОП-30 может ухудшить метрики, связанные с позициями от ТОП-30 до ТОП-100, так как у нас просто не будет данных, и нам придется отказаться от этих метрик.

Но основная проблема, на мой взгляд ,в том, что Яндекс уже не может отдавать честные ТОП-100 результатов. Мы в Сравни.ру еще полгода назад заметили, что с 30 мест выдача может дублироваться результатами из ТОП-10 или ТОП-20, особенно, если при просмотре вы не кликали на результаты до ТОП-30. Таким образом, Яндекс не хочет строить независимый рейтинг из ТОП-100, он хочет решить проблему пользователя, и, если на его взгляд вы пропустили сайты, которые могли решить проблему, он покажет вам их снова. Такое происходит не со всеми запросами, но тренд уже намечен, возможно, в будущем это будет для многих результатов поиска.

Миндубаев Рамазан, Руководитель SEO отдела в TRINET.Group:

При парсинге данных поисковой выдачи важно получать именно тот слепок, что видит пользователь, чтобы формировать правильные выводы. Иногда бывает так, что XML выдача Яндекс отличается от “живой” выдачи, а парсинг данных без регионального IP в Google содержит недостоверную информацию. При этом парсить, через XML в разы дешевле, поэтому все зависит от требований к достоверности и допустимых погрешностей.

Задач для аналитики в SEO множество, выделю основные и укажу свои рекомендации по необходимой полноте данных:

Съем позиции в поисковой выдачи для расчета % в ТОП.

Важно понимать, что уже заняло позиции в ТОП-10, что близко в ТОП-30, и фактический осталось немного дотянуть до нужного, ТОП-100 необходим, чтобы понять, есть ли уже ранжирование у запроса, либо у посадочной страницы, есть проблемы с ранжированием и стоит разобраться и найти причины.Парсинг URLs конкурентов из ТОП.

Необходимо для множества операций, например проведение группировки (кластеризации) по ТОПу, в 90% случаев производится по ТОП-10, реже используют ТОП20-30 и выше.

Извлечение данных для последующего анализа, например наличие определенного контента, мета-тегов, количества и плотности вхождений и т.д, обычно используются конкуренты из ТОП-10, так как они сделали все корректно с точки зрения ПС, иначе их не было бы в ТОП.

Построение видимости проектов, необходимо для сервисов с имеющейся базой данных, например: Ahrefs, SemRush, keys.so, SerpStat и т.д., обычно парсинг идет ТОП50-100.Парсинг заголовков и описания сниппетов.

Полезно, как для анализа оптимизации, что использует поисковая систем при выводе на тот или иной запрос, при проведение анализа достаточно анализировать ТОП-10.

Анализ подсветок, обычно достаточно использовать ТОП-50, чаще всего там присутствует все необходимое.

Анализ коммерческости, интента запроса, для анализа достаточно использовать данные из ТОП10-30. Можно проводить, как через анализ сниппетов, так и через извлечение контента страницы и его оценку.

Вычление тематико-задающих фраз (обычно, в Рунете их называют LSI фразы, хотя это некорректно), ТОП30-50 достаточно для их вычления и нахождения закономерностей.

Задач может быть действительно много, выше я обозначил лишь основные, с которыми мы сталкиваемся наиболее часто.